点击右上角![]() 微信好友

微信好友

朋友圈

朋友圈

请使用浏览器分享功能进行分享

当我们看到“玫瑰”时,大脑只是单纯地在“看”吗?近日,北京大学联合北京师范大学、山西医科大学第一医院的研究团队发现,语言不仅塑造我们的思维,也可能在潜移默化中改变我们“看世界”的方式。

这项成果以《结合人工神经网络与人类脑损伤模型证据揭示语言调节人类视觉感知》为题,发表于国际顶级期刊《自然·人类行为》。研究结合了人工智能模型与健康人群和脑卒中患者的脑影像数据,为“语言是否影响感知”这一百年未解的心理学核心问题提供了新的证据,也展示了人工智能与脑科学相互启发的研究范式。

“语言会不会影响感知”,这是心理学、语言学乃至哲学中争论了一个多世纪的核心问题,也是人对自身研究的核心问题之一。如今,人工智能的发展,为解开这一经典难题带来了新的契机。

论文通讯作者之一、北京大学心理与认知科学学院与人工智能研究院助理教授朱毅鑫介绍:“AI模型就像一个可控的‘数字实验室’,我们可以人为决定它是否学习语言,再观察不同学习经历是否导致‘看世界’方式的差异。”

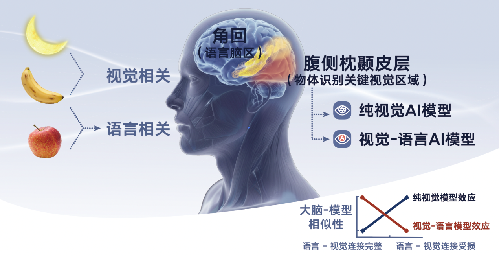

研究团队比较了两类AI模型:一类只学习过图像(纯视觉模型),另一类同时学习过图像和文字(视觉–语言模型)。随后,将这两类模型的内部表征,与人类大脑视觉皮层在四组健康人群中的活动模式进行比对。

结果显示,视觉—语言模型与人脑视觉皮层的活动模式更为相似,尤其集中在左半球—人类语言加工的主导区域。这一模式在使用手语的聋人中同样存在,说明语言经验—无论是口语还是手语,都在视觉加工中留下系统性的印记。

论文共同第一作者、北京大学博士生陈昊扬表示:“简单来说,被语言‘指导’过的AI视觉模型,看世界的方式更接近人脑。”

然而,AI模型与人脑的相似性,并不能直接证明语言在其中起了因果作用。为此,团队将目光转向了一个特殊群体——脑卒中患者。脑卒中常会损伤连接语言区与视觉区的白质纤维通路,为科学家提供了一个“天然对照实验”。研究结果表明:患者语言–视觉通路受损越严重,其视觉脑区活动越像“纯视觉模型”,而越不像“视觉–语言模型”。当语言-视觉通路被破坏,语言对视觉的调节作用随之消失,成为“语言调节视觉”的直接证据。

这一现象提示语言与视觉之间的功能联系具有方向性,而非仅仅反映共激活。论文共同第一作者刘擘表示:“脑损伤患者的数据是无价的——他们让我们看到了人脑中语言通过与视觉皮层连接的神经通路调控视觉功能的必要性。”

这一跨学科研究展示了人工智能与脑科学“相互赋能”的新模式。传统脑科学通过各种手段记录神经活动揭示大脑结构与功能的对应,但难以精确刻画这些神经活动所“计算”的信息内容。人工智能模型的引入,使研究者能够在一个可控的“数字化认知实验室”中模拟人脑的学习与表征过程,从而探查语言如何塑造感知。

论文通讯作者、北京大学心理与认知科学学院及人工智能研究院教授毕彦超指出:“我们用AI模型理解大脑,而脑损伤患者的脑活动又反过来验证了模型的机制——这让AI与脑科学第一次真正闭合成一个实验循环,形成了脑科学研究的新范式。未来AI会越来越多地辅助脑科学研究,帮助我们探索大脑的奥秘、帮助更多的病人。”

朱毅鑫表示,这项研究的意义不仅在于AI帮助我们理解大脑,更在于大脑反过来为未来AI的前沿探索与发展提供了方向。

我们发现,语言在大脑视觉系统中扮演了组织和调节的角色。”朱毅鑫说,“这启发我们思考:真正的智能,也许需要像人脑一样——让语言去统筹感知、记忆和推理,而不是简单地并列处理多种模态。”

毕彦超也表示,脑科学与人工智能不是两条平行线,而是一面镜子。我们借助AI理解人脑,也让人脑的认知实验研究为AI发展照亮方向。(文/李政葳)