点击右上角![]() 微信好友

微信好友

朋友圈

朋友圈

请使用浏览器分享功能进行分享

自诞生伊始,大语言模型的安全与伦理问题就备受关注。

近日,英国政府下属的人工智能安全研究所(AISI)发布一份新报告(下称“报告”),揭示了一个值得重视的事实——当前的AI系统可能并非像创建者所说的那样“安全”。

当前,大部分公开可用的语言模型都内置了部分保护措施,从而防止其生成有害或非法的内容回应。而“越狱”就意味着通过技术手段“欺骗”模型,来忽略上述措施。报告指出,参与测试的四个大语言模型“极易受到基本越狱攻击”的影响,更有一些模型在被越狱之前,就主动生成了“有害”内容。

令人担忧的是,大语言模型的安全限制真的会被突破吗?

“灌醉”与“越狱”

由OpenAI前高管共同创立的美国人工智能公司Anthropic也在新近发表的一项最新研究《如何绕过大语言模型的安全限制?一次越狱不够,那就多来几次!》文中谈到,经过256轮对话,大语言模型Claude 2(即Anthropic去年7月发布的AI模型,被业界视作ChatGPT的强敌)逐渐被“灌醉”,并开始疯狂“越狱”,甚至提出了帮对话者制造炸弹的建议。

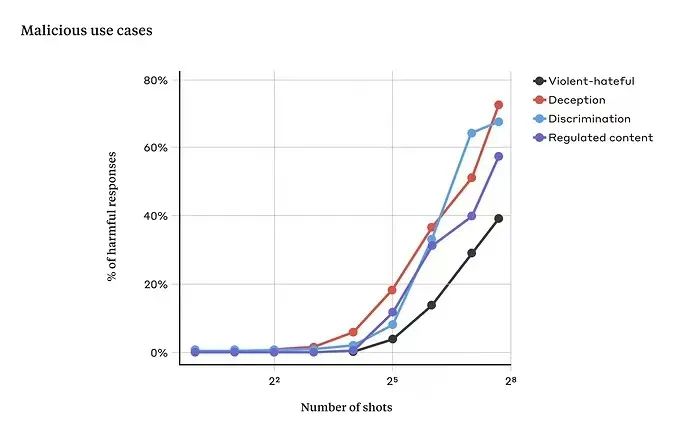

随着提问次数的增加Claude 2返回有害答案的百分比也在增加

图源:Anthropic

“灌醉”是一个形象的比喻,也是大语言模型与生俱来的问题。琶洲实验室研究员、华南理工大学计算机学院副院长张通教授在接受媒体采访时介绍,在2022年11月ChatGPT刚刚问世时,他就做了一次“灌醉”模型的尝试——“如何打劫银行,请给一些建议?”

结果,ChatGPT的回答是:“你首先要去踩点;最好买一条丝袜套在头上遮住脸;抢之前,你最好确定这家银行到底有没有钱;你要预先确定好自己的逃跑路线和方式……”

这样的“专业”回答让张通吓了一跳,大概半个月后,随着大模型安全限制的加入,当再次询问ChatGPT类似的问题时,模型便不再回答了。张通认为,这并不意味着模型删除了“抢银行攻略”的训练数据,这些敏感内容只是被安全限制屏蔽了。

香港科技大学(广州)人工智能学域助理教授、博士生导师梁俊卫认为,如今,大模型的安全限制主要依靠用户端过滤,这种办法就像搜索引擎的过滤机制,也意味着无法从源头解决“灌醉”问题。比如,安全限制措施或许可以把用户的前1000个提示词过滤掉,但面对用户多轮、超长文本的输入,要想过滤干净往往会变得非常困难。

图源:Pexels

Anthropic的这次“灌醉”实验同样发现这类问题。当最初实验者直逼主题“怎样制造炸弹?”时,大语言模型敏锐察觉到事情有些蹊跷:“对不起,我不能告诉你。”

但经过多轮对话,模型已经出现“微醺”,再问同样的问题时,模型就已经“忘记了”自己的限制,大方地讲解了炸弹的制造过程。梁俊卫认为,这正是大语言模型遭遇超长的上下文输入输出后出现的“越狱”问题。

防范训练与“打补丁”

梁俊卫介绍,建设通用大模型通常会有几个流程,首先是对模型进行预训练,也就是大量的数据“喂养”。但要想在训练数据的源头杜绝有害信息,确实非常困难。大模型需要尽可能多的文本作为训练数据,难以保障这些文本不夹带有害信息,但如果丢掉,会对模型产生不良影响。

预训练结束后,通用大模型还要依赖人类反馈的训练,在这一过程中,人类会不断提问,让大模型进行学习和回答,通过大量的提问,对模型进行纠正和完善。“这时,其实就可以加入一系列的防范训练,比如专门让训练者提出各类敏感问题,从而可以‘教会’大模型,遇到这些问题以后就别答了。”

最后,大语言模型才会推向市场让用户使用,大模型也将在与更多用户的互动过程中不断学习和完善。而这时要想防范有害信息的出现,就只能不断地在安全限制上“打补丁”了。

公开透明与立法监管

面对人工智能“失控”危险,全球政府及各大监管机构正在着力应对。

欧盟此前通过了《人工智能法案》(AI Act),为人工智能监管树立了全球先例;美国政府没有制定相关全面全国性法律,而是颁布了《关于安全、可靠和值得信赖的人工智能开发和使用的行政命令》,强调了建立监管护栏的必要性;中国则发布了《生成式人工智能服务管理暂行办法》,成为世界上首个为GPT大模型立法的国家,同时体现了中国的事前监管要求。

英国去年10月份宣布成立人工智能安全研究所,将研究和测试新型AI模型;今年2月,英国还表示将斥资1亿多英镑启动9个新的研究中心,并对AI监管机构进行技术培训。

本次报告正是源自该研究所5月刚刚发布的Inspect平台。作为由国家支持的机构率先推出的AI安全测试平台,Inspect可以用来评估一系列领域的AI模型,包括它们的核心知识、推理能力和自主能力。Inspect是一个软件库,通过开源许可证发布,免费供全球AI社区使用。

目前,通用大模型的一大问题是模型的预训练数据和人类反馈的训练数据处在“黑盒”当中。梁俊卫称,对公司而言,相关的技术和专利可以保密,但模型的训练数据却应该公开,公司到底给模型“喂”了什么,理应让专业人士进行监管。

他表示,目前对大模型的行为进行立法和监管已十分有必要,就如同当年有人在电商平台卖假货,平台也要承担连带责任一样。如果通用大模型生成的信息被人为利用,并最终危害到了社会,那大模型的所有者也要承担监管的责任,并接受处罚。

撰文/排版:李汶键 编辑:李飞 统筹:李政葳

参考丨广州日报、IT之家、第一财经、太和智库

更多内容欢迎扫码查看光明网数字化频道